フルサイズイメージ

写真1 GRAPE-DR システム

平木 敬(東京大学大学院情報理工学系研究科 創造情報学専攻 教授) 牧野淳一郎(国立天文台 理論研究部 教授) 稲葉真理(東京大学大学院情報理工学系研究科 創造情報学専攻 准教授)

Green 500 リストの第1位、第3位のシステムは、冷却方式として水冷技術(注6)あるいはラック単位水冷技術(注7)を用いている一方、GRAPE-DRは空冷技術(注8)を採用していることで、不利な条件下にあるにもかかわらず、第3位に大きく差をつけた優れた省電力性能を示しました。GRAPE-DRシステムは、空冷スーパーコンピュータとして世界一の省電力性能を持っています。

GRAPE-DRのプロセッサが日本で設計・開発されたものであることから、世界中がしのぎを削っている「スーパーコンピュータの超低消費電力化」において、日本の技術が世界のトップレベルを保持していることを示しています。また、開発した超低消費電力技術はスーパーコンピュータに限定されず、将来の超低消費電力情報システム全般を構築する基礎技術となるものと期待されます。

このリリースは下記URLからもご覧いただけます。

また、図についても、高精度写真およびエクセルファイルをダウンロード可能です。

http://grape.mtk.nao.ac.jp/press/2010-Nov-Green500.html

今回の速度・消費電力の測定は、国立天文台三鷹キャンパスに設置された GRAPE-DR システム(写真1) で行いました。測定に使ったシステムは、GRAPE-DR システム全体のうち81ノードであり、 1 ノードは GRAPE-DR ボード1枚、インテル製 Core i7 -920 CPU、 ASUS 製マザーボード、18GB DDR3 メモリからなるもので、東大・天文台で開発した GRAPE-DR ボード(写真2)以外は、一般市販部品を使用しています。

GRAPE-DR ボードを利用せず、インテル製 CPU だけを使った場合、今回測定対象にした HPL ベンチマークでの消費電力あたりの性能は 250Mflops/W (1ワットあたり 1億5千万回の演算)程度となります。 GRAPE-DR ボードを使うことで、電力あたり性能を約6 倍の 1448.03 Mflops/W に引き上げることができました。 今回、電力あたり性能を更に約1.8倍改善したベース技術は以下の通りです。

また、2017年前後に利用可能な半導体テクノロジ、冷却テクノロジを仮定すると、今回用いたGRAPE-DRアーキテクチャ技術を用い、100Gflops/Wレベルの省電力性能を実現することが可能と考えています。

なお本発表は、文部科学省科学技術振興調整費「分散共有型研究データ利用基盤の整備」で得られた成果に基づいています。

Little Green 500 リスト http://www.green500.org/lists/2010/11/little/list.php

○東京大学大学院情報理工学系研究科 教授 平木敬 Tel:090-6482-9169 / Fax:03-3818-1073 / e-mail:hiraki@is.s.u-tokyo.ac.jp ○国立天文台理論研究部 教授 牧野淳一郎 Tel:0422-34-3738 / Fax:0422-34-3746 / e-mail:makino@cfca.jp ○東京大学大学院情報理工学系研究科 准教授 稲葉真理 Tel:03-5841-4110 / Fax:03-3818-1073 / e-mail: mary@is.s.u-tokyo.ac.jp

> 付録3にGreen500の規則を示す。(http://www.green500.org/)

(注2)GRAPE-DR:東京大学・国立天文台が共同開発したスーパーコンピュータシステム。通常の PC クラスタに独自開発した GRAPE-DR プロセッサを搭載したアクセラレータボードを付加することで、多様なアプリケーションに対して高い性能を実現しています。 (http://grape-dr.adm.s.u-tokyo.ac.jp/)

(注3)HPL ベンチマーク(High Performance Linpack): 多様なスーパーコンピュータの性能評価法としてもっとも普及し、上位 500 システムの順位付けを出す Top 500 で用いられているベンチマーク。巨大な連立一次方程式を直接法で解くことを要求します。

(注4)Mflops/W:プログラム実行において、1Wの電力で実行できる浮動小数点演算回数(単位は100万演算)。最新の家庭用PCを用いると約250 Mflops/W、携帯用ノートPCを用いると約500Mflops/Wの省電力性能です。

(注5)Little Green 500リスト: 2009年 11月から Little Green 500 リスト として対象となるシステムの最低性能を小型システム側に広げ、過去 19ヶ月の間に Top 500 にランク入りできる性能があるシステムについて演算性能/消費電力比のリストを作成したもの。 2010年6月のLittle Green 500リストでは、GRAPE-DRシステムが第1位。

(注6)水冷技術:プロセッサチップなどに直接冷水が通る熱交換器を付け、プロセッサが出す熱を冷却する技術。古くはメインフレームなど大消費電力システムの冷却技術として多用されたが、コストやシステム設置が大変なこと、システムの消費電力の低下から使われなくなりました。

最近はチップ温度が同じ場合にはより少ない電力で冷却を実現し、更にチップ温度を下げれば半導体の微細化に伴うリーク電流が激減することから、省電力化の方法として再び使われるようになってきています。日本の次世代スパコン「京」、IBMの省エネルギー・スパコン「Aquasar」や、開発中の20Pflopsスパコン「BlueGene/Q」、「BlueWater」では水冷技術が使われています。

(注7)ラック単位水冷技術:前記水冷技術が、水により直接チップを冷却することに対し、ラック単位に液冷熱交換器を入れ、閉鎖されたラック内の空気循環によりプロセッサを冷却する技術。閉じたラック内で熱交換器を含め空気循環させるため、ラック内温度を低く保ち、省電力化するとともに、プロセッサ密度を上げることが可能になります。ラック単位液冷技術は、2004年にCERNで開発されたLHC加速器用クラスタシステムに導入され、大きな成果を得た後、Cray XT-6, 中国の天河-1A, LenovoのDeepComp7000、TSUBAME 2.0などで広く使われています。

ラック単位水冷技術には多くの利点がありますが、ラックへ往復する冷媒の配管が必要であり、空冷スーパーコンピュータより設置先に制限が付くことが欠点です。

(注8)空冷技術:プロセッサチップなどコンピュータの構成要素を全てファン等による空気の流れで冷却する放熱技術。コンピュータが誕生して以来、常に最も使われる放熱技術でしたが、乱流を用いた高レイノルズ数領域での衝突冷却の進展により、後記水冷に匹敵する冷却能力が実現し、パソコンからスーパーコンピュータまでの全ての領域で空冷システムが可能となっています。

空冷システムは騒音が出るという問題点を除けばどこにでも設置できる便利さを持ち、現在でも主流の冷却技術となっています。

(注9)BlueGene/Q:米国IBM社が2012年に20Pflopsの性能を実現することを目標として開発しているスーパーコンピュータ。1チップ16コアのプロセッサを水冷技術により高度に集積し、96ラックで20Pflopsを実現する予定です。

(注10)IEEE (The Institute of Electrical and Electronics Engineers, Inc ):アメリカに本部を持つ世界的な電気・電子技術の学会で、活発な標準化活動も行っています。

(写真は全て三浦健司撮影)

フルサイズイメージ

写真1 GRAPE-DR システム

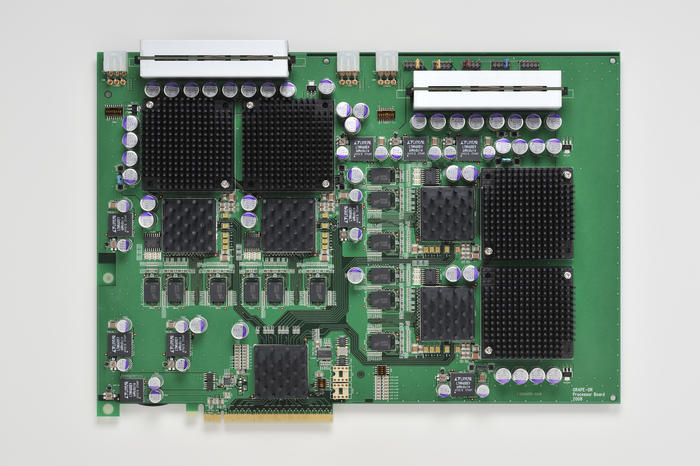

フルサイズイメージ

写真2 今回使用したGRAPE-DR 4プロセッサボード

| (付録1) 演算性能/消費電力比の推移 |

| 年 | 性能・電力比 | HPL性能(Tflops) | 研究機関名 | コンピュータ名 |

| 2007/11 | 357 | 13.9 | Council Daresbury Lab | BlueGene/P |

| 2008 /6 | 488 | 9.3 | Fraunhofer IT WM | BladeCenterQS22 PowerXCell 8 3.2GHz |

| 2008/11 | 536 | 18.6 | University of Warsaw | BladeCenterQS22 PowerXCell 8 4GHz |

| 2009 /6 | 536 | 18.6 | University of Warsaw | BladeCenterQS22 PowerXCell 8 4GHz |

| 2009/11 | 722 | 55.7 | Forschungszentrun Juelich | QPACE Cluster PowerXCell 8i 3.2GHz |

| 2010/6 | 815 | 23.4 | 東京大学/.国立天文台 | GRAPE-DR (Little Green500) |

| 2010/11 | 1680 | 65.3 | IBM T.J. ワトソン研究センタ | BlueGene/Q |

(付録2) Green 500 リストでの主要システム省電力性能の比較

(付録3)Green500の規則。バージョン 0.9 (日本語訳 平木 敬)

[ルール1] Green500リストの対象は、現行Top500リストの500位システム以上の性能を持 つスーパーコンピュータである。

[ルール2] Green500リストの性能は、HPLベンチマークを実行している時の実行性能(Flops)を、平均消費電力(W)で除した数値である。

[ルール3] Green500リストに申請する時のHPL実行性能は、TOP500 リストの500位の性能より高い限り、TOP500 リストに掲載されるRmax性能と一致していなくてよいが、Top500リスト用性能測定で用いた全てのコアを使うことが必要である。DVFS(可変電圧・周波数による省電力技術)や他の省電力方法を用いて良い。Rmaxを実行する時の演算性能/消費電力比と当該スーパーコンピュータ全体での最良の演算性能/消費電力比が異なる場合は、双方を報告することが望ましい。

[ルール4] スーパーコンピュータのサブコンポーネントとは、スーパーコンピュータの一部であり、電力を、その部分だけに関して測定できる単位である。電力測定は、1つのサブコンポーネントに対して行うこと。

[ルール5]サブコンポーネントの電力は、ACコンセントまたはスーパーコンピュータ用の電力源において測定すること。

[ルール6] 測定に用いるAC電源は、定格の +/- 1% 以内の電圧、周波数であり、AC電源電圧の総歪率が2% THD 以下であること。周囲温度が摂氏15度から25度の間であり、周囲の相対湿度が 30-80%であること。

[ルール7] 測定時のHPL実行には Top500リスト申請時のルールが全て適用されていること。Rmax電力を測定する場合(それが報告される場合)、電力測定は、Top500リストへ申請するためのHPL実行と同時に行われること。

[ルール8] 真のRMS値(実効値)が測定できcrest factor(平均電力値に対して測定可能なピーク電力の比率)が5以上の電力測定器を使用すること。システム中からランダムに選択され、[4]で規定されるサブコンポーネントの消費電力を測定すること。測定時に使用する電力測定器のフルスケール値をcrest factorで乗じた値は、オシロスコープ(またはディジタルマルチメータ)で観測したピーク値より大きいこと。

[ルール9] 瞬間的な消費電力を、少なくとも1秒間に一回記録して電力測定すること。電力計には別のPCかノートPCが接続され、電子的に値を記録すること。同じ実験を、同じサブコンポーネントに対してもう一回繰り返すこと。もし、同一サブコンポーネントの平均消費電力が1%以上変化するならば、別のサブコンポーネントを用いて、測定を繰り返すこと。

[ルール10] 測定するスーパーコンピュータは、測定前に少なくとも15分間電源が入っている状態でウォームアップを行うこと。

[ルール11] HPLベンチマーク実行開始から、HPLベンチマーク全実行時間の10%以上の時間が経過後に、電力の測定を開始すること。

[ルール12] HPLベンチマーク全実行時間の20%以上の期間について電力測定を行うこと。

[ルール13] スーパーコンピュータ全体がタスクを実行する際の消費電力を、サブコンポーネントの消費電力にシステム全体におけるサブコンポーネント数を乗じて求めること。